|

查看: 266|回复: 8

|

26岁OpenAI举报人'疑自杀',死前揭ChatGPT黑幕

[复制链接]

[复制链接]

|

|

|

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

26岁的OpenAI吹哨人,在发出公开指控不到三个月,被发现死在自己的公寓中。法医认定,死因为自杀。那么,他在死前两个月发表的一篇博文中,都说了什么?

就在刚刚,消息曝出:OpenAI吹哨人,在家中离世。

曾在OpenAI工作四年,指控公司侵犯版权的Suchir Balaji,上月底在旧金山公寓中被发现死亡,年仅26岁。

旧金山警方表示,11月26日下午1时许,他们接到了一通要求查看Balaji安危的电话,但在到达后却发现他已经死亡。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

这位吹哨人手中掌握的信息,原本将在针对OpenAI的诉讼中发挥关键作用。

如今,他却意外去世。

法医办公室认定,死因为自杀。警方也表示,“并未发现任何他杀证据”。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

他在X上的最后一篇帖子,正是介绍自己对于OpenAI训练ChatGPT是否违反法律的思考和分析。

他也强调,希望这不要被解读为对ChatGPT或OpenAI本身的批评。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

如今,在这篇帖子下,网友们纷纷发出悼念。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

Suchir Blaji的朋友也表示,他人十分聪明,绝不像是会自杀的人。

吹哨人警告:OpenAI训练模型时违反原则

Suchir Balaji曾参与OpenAI参与开发ChatGPT及底层模型的过程。

今年10月发表的一篇博文中他指出,公司在使用新闻和其他网站的信息训练其AI模型时,违反了“合理使用”原则。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

博文地址:https://suchir.net/fair_use.html

然而,就在公开指控OpenAI违反美国版权法三个月之后,他就离世了。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

为什么11月底的事情12月中旬才爆出来,网友们也表示质疑

其实,自从2022年底公开发布ChatGPT以来,OpenAI就面临着来自作家、程序员、记者等群体的一波又一波的诉讼潮。

他们认为,OpenAI非法使用自己受版权保护的材料来训练AI模型,公司估值攀升至1500亿美元以上的果实,却自己独享。

今年10月23日,《纽约时报》发表了对Balaji的采访,他指出,OpenAI正在损害那些数据被利用的企业和创业者的利益。

“如果你认同我的观点,你就必须离开公司。这对整个互联网生态系统而言,都不是一个可持续的模式。”

一个理想主义者之死

Balaji在加州长大,十几岁时,他发现了一则关于DeepMind让AI自己玩Atari游戏的报道,心生向往。

高中毕业后的gap year,Balaji开始探索DeepMind背后的关键理念——神经网络数学系统。

Balaji本科就读于UC伯克利,主修计算机科学。在大学期间,他相信AI能为社会带来巨大益处,比如治愈疾病、延缓衰老。在他看来,我们可以创造某种科学家,来解决这类问题。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

2020年,他和一批伯克利的毕业生们,共同前往OpenAI工作。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

然而,在加入OpenAI、担任两年研究员后,他的想法开始转变。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

在那里,他被分配的任务是为GPT-4收集互联网数据,这个神经网络花了几个月的时间,分析了互联网上几乎所有英语文本。

Balaji认为,这种做法违反了美国关于已发表作品的“合理使用”法律。今年10月底,他在个人网站上发布一篇文章,论证了这一观点。

目前没有任何已知因素,能够支持“ChatGPT对其训练数据的使用是合理的”。但需要说明的是,这些论点并非仅针对ChatGPT,类似的论述也适用于各个领域的众多生成式AI产品。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

根据《纽约时报》律师的说法,Balaji掌握着“独特的相关文件”,在纽约时报对OpenAI的诉讼中,这些文件极为有利。

在准备取证前,纽约时报提到,至少12人(多为OpenAI的前任或现任员工)掌握着对案件有帮助的材料。

在过去一年中,OpenAI的估值已经翻了一倍,但新闻机构认为,该公司和微软抄袭和盗用了自己的文章,严重损害了它们的商业模式。

诉讼书指出——

微软和OpenAI轻易地攫取了记者、新闻工作者、评论员、编辑等为地方报纸作出贡献的劳动成果——完全无视这些为地方社区提供新闻的创作者和发布者的付出,更遑论他们的法律权利。

而对于这些指控,OpenAI予以坚决否认。他们强调,大模型训练中的所有工作,都符合“合理使用”法律规定。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

为什么说ChatGPT没有“合理使用”数据

为什么OpenAI违反了“合理使用”法?Balaji在长篇博文中,列出了详尽的分析。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

他引用了1976年《版权法》第107条中对“合理使用”的定义。

是否符合“合理使用”,应考虑的因素包括以下四条:

(1)使用的目的和性质,包括该使用是否具有商业性质或是否用于非营利教育目的;(2)受版权保护作品的性质;(3)所使用部分相对于整个受版权保护作品的数量和实质性;(4)该使用对受版权保护作品的潜在市场或价值的影响。

按(4)、(1)、(2)、(3)的顺序,Balaji做了详细论证。

因素(4):对受版权保护作品的潜在市场影响

由于ChatGPT训练集对市场价值的影响,会因数据来源而异,而且由于其训练集并未公开,这个问题无法直接回答。

不过,某些研究可以量化这个结果。

《生成式AI对在线知识社区的影响》发现,在ChatGPT发布后,Stack Overflow的访问量下降了约12%。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

此外,ChatGPT发布后每个主题的提问数量也有所下降。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

提问者的平均账户年龄也在ChatGPT发布后呈上升趋势,这表明新成员要么没有加入,要幺正在离开社区。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

而Stack Overflow,显然不是唯一受ChatGPT影响的网站。例如,作业帮助网站Chegg在报告ChatGPT影响其增长后,股价下跌了40%。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

当然,OpenAI和谷歌这样的模型开发商,也和Stack Overflow、Reddit、美联社、News Corp等签订了数据许可协议。

但签署了协议,数据就是“合理使用”吗?

总之,鉴于数据许可市场的存在,在未获得类似许可协议的情况下使用受版权保护的数据进行训练也构成了市场利益损害,因为这剥夺了版权持有人的合法收入来源。

因素(1):使用目的和性质,是商业性质,还是教育目的

书评家可以在评论中引用某书的片段,虽然这可能会损害后者的市场价值,但仍被视为合理使用,这是因为,二者没有替代或竞争关系。

这种替代使用和非替代使用之间的区别,源自1841年的“Folsom诉Marsh案”,这是一个确立合理使用原则的里程碑案例。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

问题来了——作为一款商业产品,ChatGPT是否与用于训练它的数据具有相似的用途?

显然,在这个过程中,ChatGPT创造了与原始内容形成直接竞争的替代品。

比如,如果想知道“为什么在浮点数运算中,0.1+0. 2=0.30000000000000004?”这种编程问题,就可以直接向ChatGPT(左)提问,而不必再去搜索Stack Overflow(右)。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

因素(2):受版权保护作品的性质

这一因素,是各项标准中影响力最小的一个,因此不作详细讨论。

因素(3):使用部分相对于整体受保护作品的数量及实质性

考虑这一因素,可以有两种解释——

(1)模型的训练输入包含了受版权保护数据的完整副本,因此“使用量”实际上是整个受版权保护作品。这不利于“合理使用”。

(2)模型的输出内容几乎不会直接复制受版权保护的数据,因此“使用量”可以视为接近零。这种观点支持“合理使用”。

哪一种更符合现实?

为此,作者采用信息论,对此进行了量化分析。

在信息论中,最基本的计量单位是比特,代表着一个是/否的二元选择。

在一个分布中,平均信息量称为熵,同样以比特为单位(根据香农的研究,英文文本的熵值约在每个字符0.6至1.3比特之间)。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

两个分布之间共享的信息量称为互信息(MI),其计算公式为:

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

在公式中,X和Y表示随机变量,H(X)是X的边际熵,H(X|Y)是在已知Y的情况下X的条件熵。如果将X视为原创作品,Y视为其衍生作品,那么互信息I(X;Y)就表示创作Y时借鉴了多少X中的信息。

对于因素3,重点关注的是互信息相对于原创作品信息量的比例,即相对互信息(RMI),定义如下:

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

此概念可用简单的视觉模型来理解:如果用红色圆圈代表原创作品中的信息,蓝色圆圈代表新作品中的信息,那么相对互信息就是两个圆圈重叠部分与红色圆圈面积的比值:

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

在生成式AI领域中,重点关注相对互信息(RMI),其中X表示潜在的训练数据集,Y表示模型生成的输出集合,而f则代表模型的训练过程以及从生成模型中进行采样的过程:

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

在实践中,计算H(Y|X)——即已训练生成模型输出的信息熵——相对容易。但要估算H(Y)——即在所有可能训练数据集上的模型输出总体信息熵——则极其困难。

至于H(X)——训练数据分布的真实信息熵——虽然计算困难但仍是可行的。

可以作出一个合理假设:H(Y) ≥ H(X)。

这个假设是有依据的,因为完美拟合训练分布的生成模型会呈现H(Y) = H(X)的特征,同样,过度拟合并且记忆训练数据的模型也是如此。

而对于欠拟合的生成模型,可能会引入额外的噪声,导致H(Y) > H(X)。在H(Y) ≥ H(X)的条件下,就可以为RMI确定一个下限:

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

这个下限背后的基本原理是:输出的信息熵越低,就越可能包含来自模型训练数据的信息。

在极端情况下,就会导致“内容重复输出”的问题,即模型会以确定性的方式,输出训练数据中的片段。

即使在非确定性的输出中,训练数据的信息仍可能以某种程度被使用——这些信息可能被分散融入到整个输出内容中,而不是简单的直接复制。

从理论上讲,模型输出的信息熵并不需要低于原始数据的真实信息熵,但在实际开发中,模型开发者往往倾向于选择让输出熵更低的训练和部署方法。

这主要是因为,熵值高的输出在采样过程中会包含更多随机性,容易导致内容缺乏连贯性或产生虚假信息,也就是“幻觉”。

如何降低信息熵?

数据重复现象

在模型训练过程中,让模型多次接触同一数据样本是一种很常见的做法。

但如果重复次数过多,模型就会完整地记下这些数据样本,并在输出时简单地重复这些内容。

举个例子,我们先在莎士比亚作品集的部分内容上对GPT-2进行微调。然后用不同颜色来区分每个token的信息熵值,其中红色表示较高的随机性,绿色表示较高的确定性。

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

当仅用数据样本训练一次时,模型对“First Citizen”(第一公民)这一提示的补全内容虽然不够连贯,但显示出高熵值和创新性。

然而,在重复训练十次后,模型完全记住了《科利奥兰纳斯》剧本的开头部分,并在接收到提示后机械地重复这些内容。

在重复训练五次时,模型表现出一种介于简单重复和创造性生成之间的状态——输出内容中既有新创作的部分,也有记忆的内容。

假设英语文本的真实熵值约为每字符0.95比特,那么这些输出中就有大约

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

的内容是来自训练数据集。

强化学习机制

ChatGPT产生低熵输出的主要原因在于,它采用了强化学习进行后训练——特别是基于人类反馈的强化学习(RLHF)。

RLHF倾向于降低模型的熵值,因为其主要目标之一是降低“幻觉”的发生率,而这种“幻觉”通常源于采样过程中的随机性。

理论上,一个熵值为零的模型可以完全避免“幻觉”,但这样的模型实际上就变成了训练数据集的简单检索工具,而非真正的生成模型。

下面是几个向ChatGPT提出查询的示例,以及对应输出token的熵值:

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

根据

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

,可以估计这些输出中约有73%到94%的内容,对应于训练数据集中的信息。

如果考虑RLHF的影响(导致

26岁OpenAI举报人疑自杀,死前揭ChatGPT黑幕

),这个估计值可能偏高,但熵值与训练数据使用量之间的相关性依然十分明显。

例如,即使不了解ChatGPT的训练数据集,我们也会发现它讲的笑话全是靠记忆,因为这些内容几乎都是以确定性方式生成的。

这种分析方法虽然比较粗略,但它揭示了训练数据集中的版权内容如何影响模型输出。

但更重要的是,这种影响十分深远。即使是对因素(3)做出更宽松的解释,也难以支持“合理使用”的主张。

最终,Suchir Balaji得出结论:从这4个因素来看,它们几乎都不支持“ChatGPT在合理使用训练数据”。

10月23日,Balaji发出这篇博客。

一个月后,他死于自己的公寓。 |

|

|

|

|

|

|

|

|

|

|

|

发表于 16-12-2024 01:18 AM

|

显示全部楼层

发表于 16-12-2024 01:18 AM

|

显示全部楼层

|

|

|

|

|

|

|

|

|

|

|

楼主 |

发表于 16-12-2024 11:43 PM

|

显示全部楼层

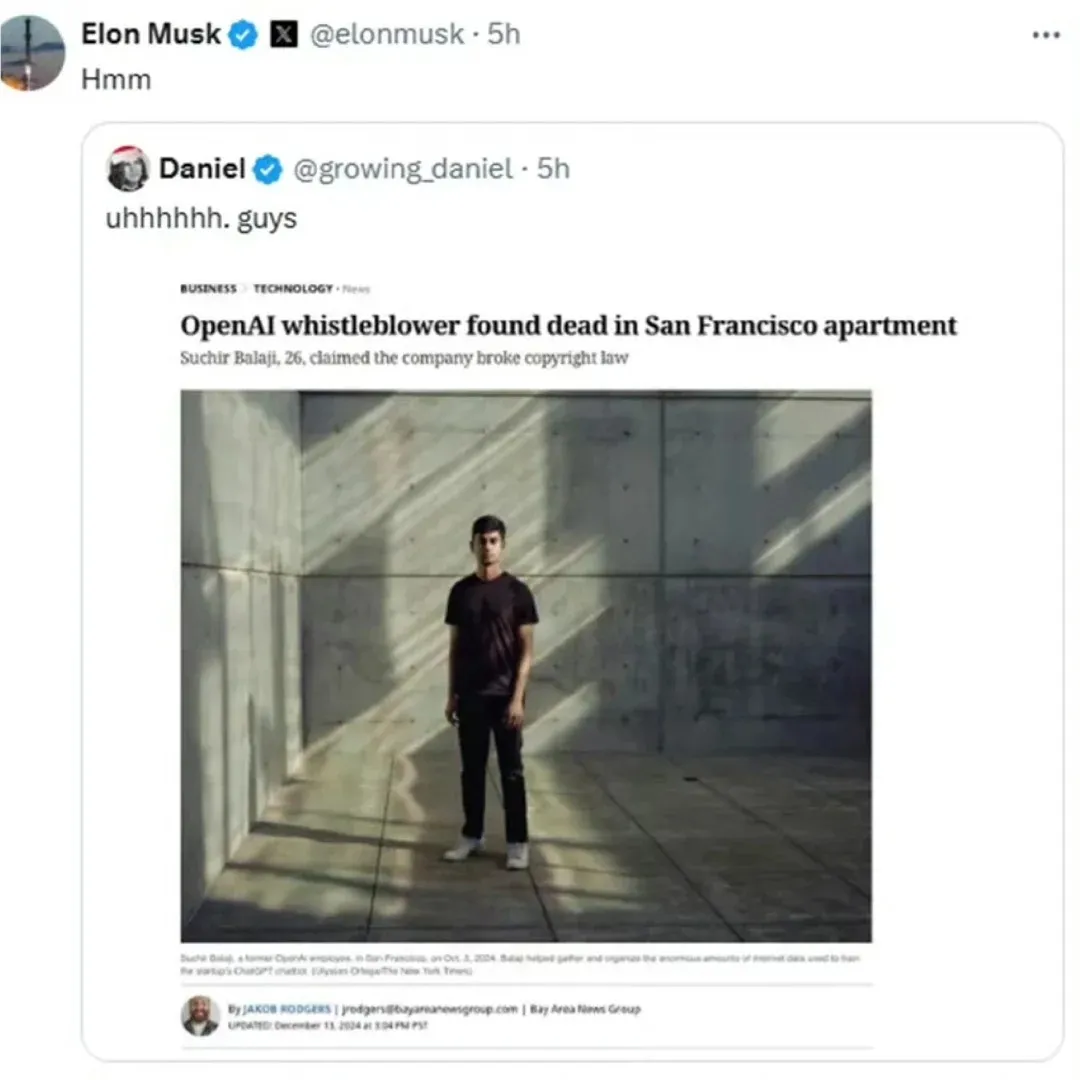

举报了OpenAi的26岁小伙被曝自杀,马斯克震惊,太诡异了!

26岁的前OpenAI研究员Suchir Balaji,被发现在其公寓内去世,法医鉴定结果为自杀。

Suchir Balaji毕业于加州大学伯克利分校计算机科学专业,并曾是OpenAI核心团队的成员之一,参与了GPT-4项目的训练工作。他自学生时代起就对人工智能的潜力抱有理想,相信AI技术能够治疗疾病和延长寿命。然而,在加入OpenAI并参与ChatGPT项目后,他开始对行业的实践产生怀疑。离职之后,他公开质疑OpenAI在开发ChatGPT时可能违反了美国的版权法规,认为这种未经授权使用数据的做法侵犯了版权所有者的权益。

Image

在10月份发表的文章中,Balaji探讨了生成式AI是否符合“合理使用”的法律标准。他指出,ChatGPT的推出导致Stack Overflow和Chegg等平台的用户访问量大幅下降,从而损害了内容提供者的经济利益。他提出,OpenAI在训练ChatGPT时可能使用了大量未经授权的受版权保护的数据,这种行为剥夺了数据所有者的收入。即使AI的输出没有直接复制原始数据,通过强化学习,输出中可能仍然包含了训练数据的关键信息。Balaji掌握了“独特且关键的文件”,他的揭露对于针对OpenAI和微软等公司的诉讼至关重要。根据美国《1976年版权法》第107条,他详细分析了ChatGPT作为一款商业产品,与原始数据用途相同,不符合“转化性”要求,且在互联网上大多数数据都受到版权保护,训练过程中复制了大量完整数据,对内容提供商的市场价值产生了重大负面影响。Balaji得出结论,ChatGPT的训练方法难以满足“合理使用”的标准。

Image

然而,在他公开提出这些指控三个月后,Balaji被发现在家中去世。尽管警方表示没有他杀的迹象,但他的一些朋友认为他是一个“聪明且乐观的人,不可能自杀”。Balaji的去世不仅是一个悲剧,也反映了AI行业在快速发展中所面临的法律和伦理挑战。这位曾经对AI抱有希望的青年,在目睹行业的问题后,可能经历了理想的幻灭。Balaji曾在博客中表达过他的信念:“人工智能的未来应该服务于所有人,而不是成为少数人的利益工具。 |

|

|

|

|

|

|

|

|

|

|

|

楼主 |

发表于 17-12-2024 10:00 PM

|

显示全部楼层

|

|

|

|

|

|

|

|

|

|

|

发表于 18-12-2024 08:35 AM

来自手机

|

显示全部楼层

发表于 18-12-2024 08:35 AM

来自手机

|

显示全部楼层

跟波音吹哨人一样, 把实话说出来之后命就没了!

这里的美吹还把美国当神拜哦, 哼, 简直是脑袋有问题!  |

|

|

|

|

|

|

|

|

|

|

|

发表于 18-12-2024 09:08 AM

|

显示全部楼层

发表于 18-12-2024 09:08 AM

|

显示全部楼层

本帖最后由 lcw9988 于 18-12-2024 09:17 AM 编辑

就一个小粉红和中华胶抱团在嘴炮, 有证据吗? 习狗在中南海扑街责任也在美方对吗?

26岁能懂得多少? 就一个才工作两年的新人能有什么大把柄在手上? 须要浪费资源杀他? 编故事都得先想好啦, 更何况又拿不出证据, 大傻B中华胶小粉红 !

|

|

|

|

|

|

|

|

|

|

|

|

发表于 18-12-2024 09:32 AM

来自手机

|

显示全部楼层

发表于 18-12-2024 09:32 AM

来自手机

|

显示全部楼层

lcw9988 发表于 18-12-2024 09:08 AM

就一个小粉红和中华胶抱团在嘴炮, 有证据吗? 习狗在中南海扑街责任也在美方对吗?

26岁能懂得多少? 就 ...

耶, 果然把你气得跳出来了, 我成功刺中你的痛处了。

继续洗好了, 你条ngong居美吹最擅长就是帮老美洗地! 黑的也讲成白的, 死的也拗翻生的!  |

|

|

|

|

|

|

|

|

|

|

|

发表于 18-12-2024 09:33 AM

|

显示全部楼层

发表于 18-12-2024 09:33 AM

|

显示全部楼层

本帖最后由 lcw9988 于 18-12-2024 09:41 AM 编辑

有证据吗? 呸 undefined

有证据吗? 呸undefined

有证据吗? 呸 undefined

嘴炮谁不会, 低B粉红没证据只会嘴炮 ! 又tuk爆你的大烂嘴了, 你几时要报案指正open AI杀人? 又缩春了? !

|

|

|

|

|

|

|

|

|

|

|

|

发表于 18-12-2024 12:29 PM

来自手机

|

显示全部楼层

发表于 18-12-2024 12:29 PM

来自手机

|

显示全部楼层

|

|

|

|

|

|

|

|

|

| |

本周最热论坛帖子 本周最热论坛帖子

|